Send Prompt

Versende eine Text Nachricht (Prompt) an ChatGPT.

Settings

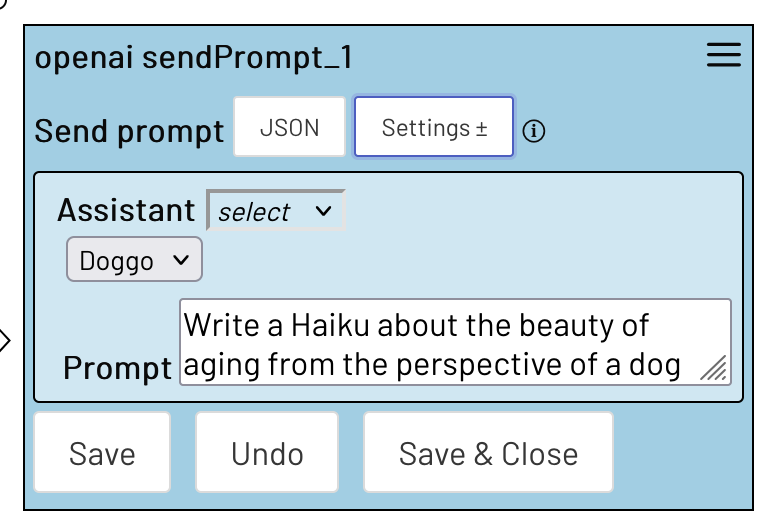

Assistant

Der OpenAI-Assistent, an den die Nachricht gehen soll.

Prompt

Die Nachricht, die gesendet werden soll

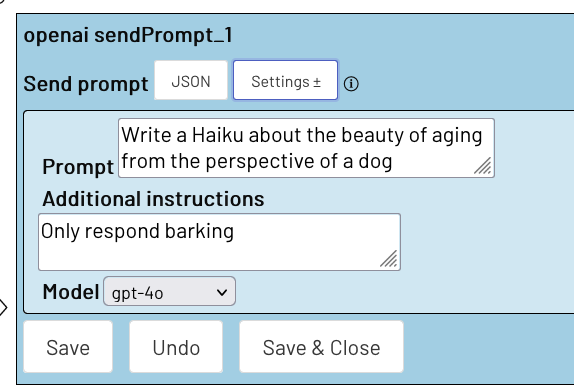

Additional Instructions

Informationen darüber, wie das Model reagieren soll.

Bei OpenAi wird zwischen 'developer', auch 'system', Nachrichten und 'user' Nachrichten unterschieden. Im Plugin kann nicht explizit zwischen den Rollen unterschieden werden. Stattdessen werden Eingaben unter

promptimmer als 'user' Nachrichten ausgewertet, während Eingaben unterAdditional instructionsimmer als 'developer' Nachrichten ausgewertet werden. Mehr dazu unter: openAi/docs/roles

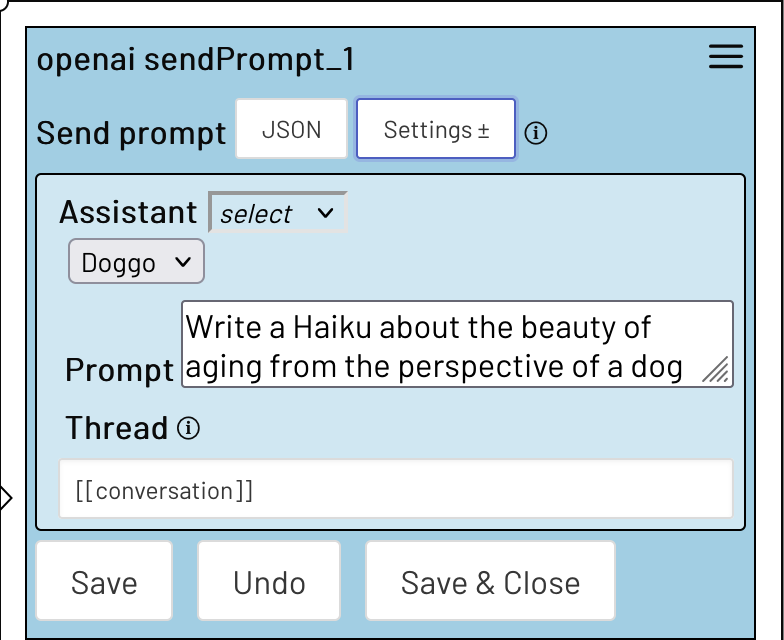

Thread

Lege fest in welchen Thread die Nachricht gepostet werden soll.

Nur wenn du einen Assistenten und einen Thread festlegst, kannst du auch wirklich aufeinander aufbauende Konversationen führen. Andernfalls kann sich das Model keine Ein/Ausgaben merken.

Das posten und die Rückgabe einer Antwort kann je nach Internetgeschwindigkeit eine längere Zeit dauern. Beachte, dass während dieser Action keine parallelen Actions in deiner Session möglich sind.

Solange du in einen Thread postest, kann dieser nicht aus einer anderen Session benutzt werden. Es ist deine Verantwortung dies zu Verhindern. Z.B. mit der on Error Action.

Model

Lege fest mit welchem Model du arbeiten möchtest. Wenn du eine Anfrage ohne Assitent machst, musst du ein Model angeben. Andernfalls wird die Einstellung aus deinem jeweiligen Assistenten übernommen.

Mehr dazu unter: openAi/docs/models

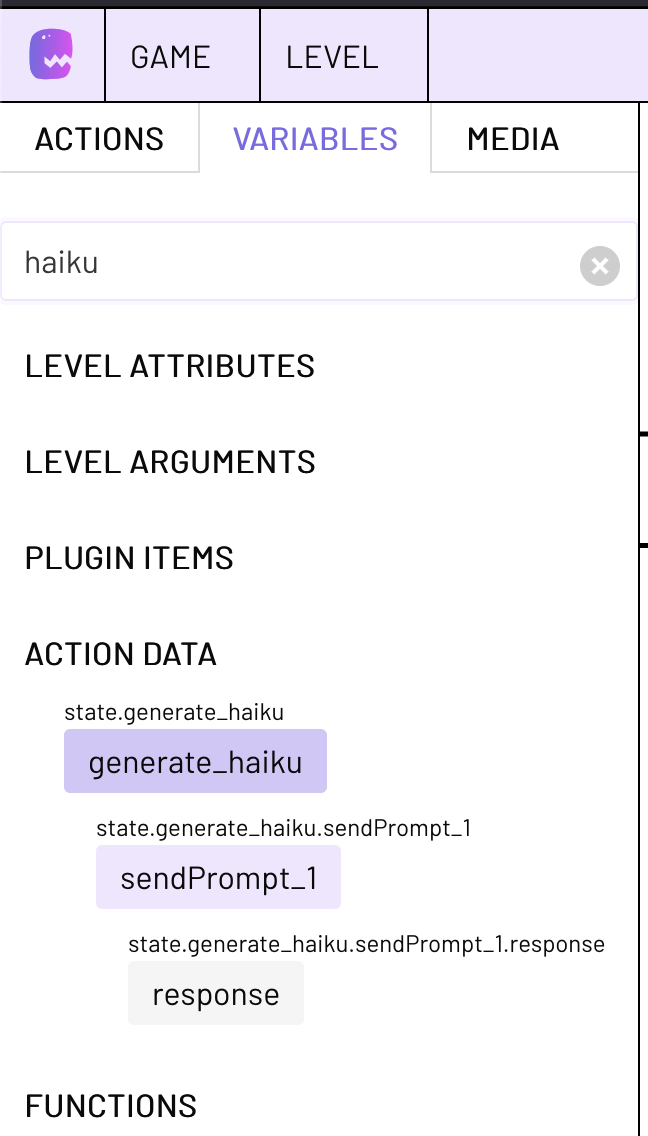

Variablen

Du kannst auf die zuletzt Eingegangene Antwort auf einen Prompt über die Send Prompt action data variable zugreifen. Nutze etwa:

[[state.MyState.sendPrompt_1.response]]

Um auf die zuletzt eingegangenen Antwort auf einen Prompt der obersten Send Prompt action im State MyState zuzugreifen.

response

Die Antwort deiner Request.

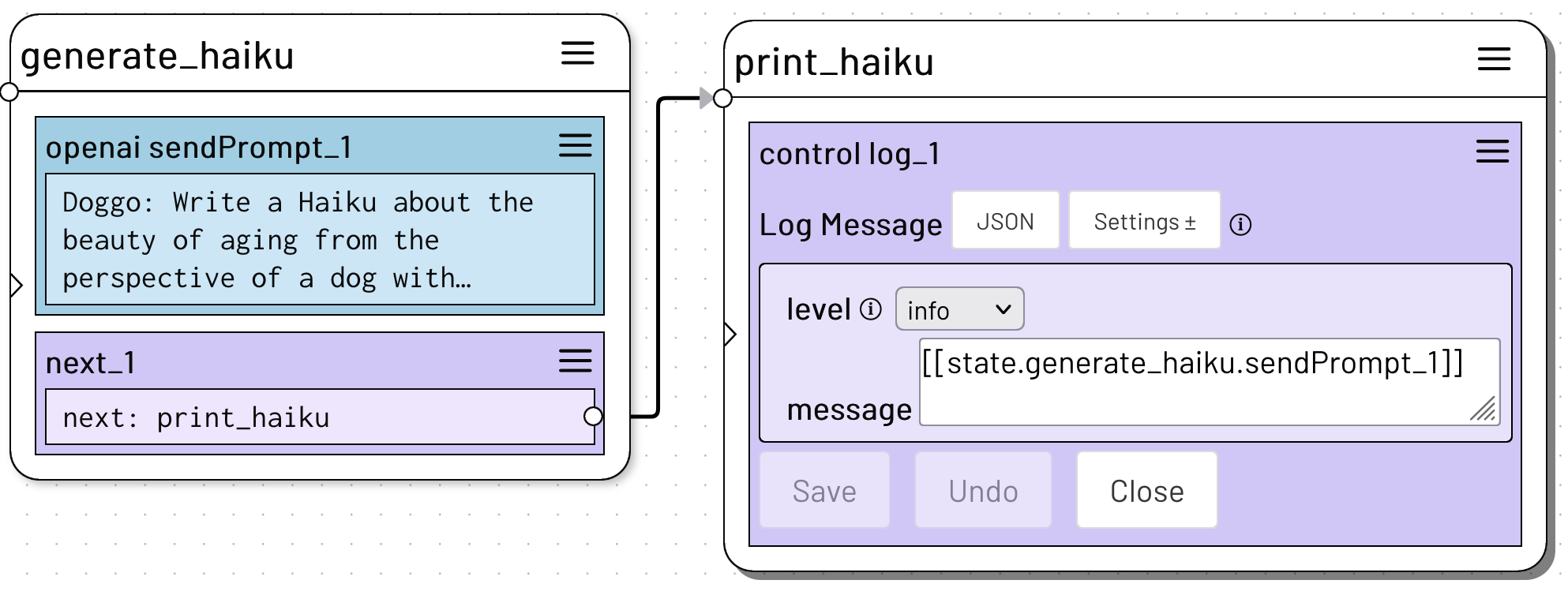

Beispiele

Je nachdem, welche Kombination von Einstellungen du auswählst, verhält sich die Action etwas anders.

Die direktest Variante ist es den Prompt und die entsprechenden Instruktionen direkt in der Action zu definieren. In dieser Variante muss allerdings auch das Model explizit ausgewählt werden und Konversationen können nicht gespeichert werden.

In der nächsten Variante wurde ein Assistent ausgewählt, jedoch kein Thread definiert. Auch hier wird die Konversation wird nicht gespeichert, aber im Hintergrund werden aber die Informationen über den Assistenten aus seinen Einstellungen an die Anfrage gehängt, sodass die von dir definierte Persönlichkeit erhalten bleibt. Es ist weiterhin möglich noch weitere Instructions über die enstprechende Action Einstellung anzuhängen.

Nur, wenn ein Assistent und ein gültiger Thread angegeben wurden ist eine aufbauende Konversation möglich.

Um die Antwort deiner Anfrage aufzurufen, schaue links in der Menüleiste unter Variablen und suche nach deinem State.

Du kannst die Antwort dann weiter verarbeiten